Industrie 4.0-Technologien

Einführung

Industrie 4.0 bezeichnet eine Zukunftsinitiative zur umfassenden Digitalisierung der industriellen Produktion, um sich für jetzige und zukünftige Anforderungen zu rüsten. Die industrielle Produktion soll mit moderner Informations- und Kommunikationstechnik verzahnt werden. Genutzt werden hierfür intelligente und digital vernetzte Systeme. Mit ihrer Hilfe soll es der Produktion ermöglicht werden weitestgehend selbstorganisiert zu agieren. In der Industrie 4.0 kommunizieren und kooperieren Menschen, Maschinen, Anlagen, Logistik und Produkte direkt miteinander.

Edge-Computing

Hintergrund Edge-Computing

Im Kontext der, durch die Verbreitung von Cloud-Computing veränderten Softwarearchitekturen, entsteht eine neue Kategorie von Geräten, die Cloud und Feld verbinden. Der Trend geht auf die sprunghafte Verbreitung von netzwerkfähigen Geräten (oft IoT-Geräte) zurück, die Daten erfassen und diese zur Weiterverarbeitung oder Speicherung mit anderen Systemen austauschen. Um diese Datenmenge nicht unverändert über die begrenzte Bandbreite an die dafür häufig eingesetzten Clouddienste zu senden, sitzt beim Edge-Computing eine Recheneinheit am Übergang zwischen einer Anzahl lokaler Geräte und der Cloud.

Projektbeschreibung

Fertigungseinheiten, cyberphysikalische Systeme, die in der diskreten Fertigung eingesetzt werden, produzieren steigende Datenmengen. Die im Folgenden durchgeführte Forschung konzentriert sich auf die Visualisierung und Analyse dieser Daten, um das Verständnis der Prozesse in der Anlage zu verbessern und Anomalien und mögliche Fehler zu entdecken.

Umsetzung

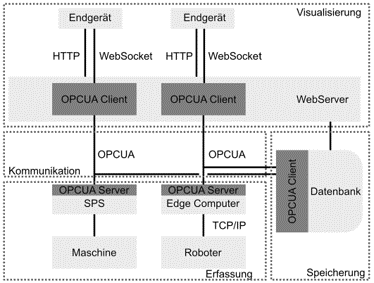

Der Zugriff auf die Daten erfolgt über das OPC UA Kommunikationsprotokoll, einen herstellerunabhängigen Standard für die Anbindung von Fertigungsanlagen.

Für Geräte, die derzeit OPC UA nicht unterstützen, wie die von Universal Robots hergestellten kollaborativen Roboter, wird diese Funktionalität durch Konzepte ergänzt, die im Bereich des Edge Computing eingeführt wurden.

Einfacher und geräteunabhängiger Zugriff auf die Daten, zwei der Hauptanforderungen, führen zur Nutzung von Web-Technologien. Dadurch können Informationen im Browser von PCs und mobilen Geräten dargestellt werden.

Ergebnisse

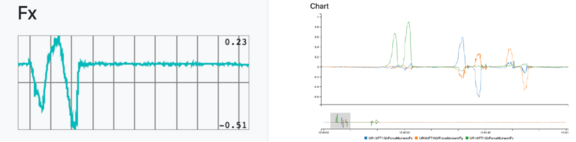

Die folgenden zwei Grafiken zeigen Beispiele für mögliche Datenvisualisierungen in der Web-Oberfläche. Die linke Grafik stellt live die Kräfte der x-Achse dar, während in der rechten Grafik die historischen Daten verschiedener Kräfte des Roboters visualisiert werden. Darüber hinaus wurden verschiedene Analysemethoden implementiert, um z.B. Minima und Maxima zu ermitteln.

Maschinelles Lernen

Hintergrund Maschinelles Lernen

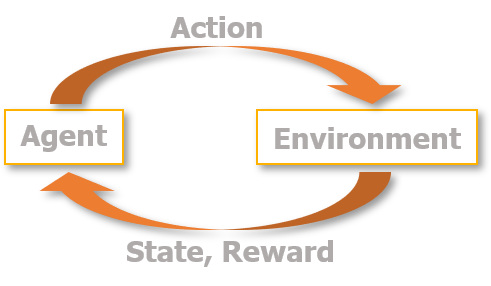

Mit Hilfe der KI-Methode des Maschinellen Lernens können intelligente Systeme neues Wissen lernen. Es wird zwischen überwachtem Lernen (Ergebnis bekannt), unüberwachtem Lernen (Ergebnis unbekannt) und bestärkendem Lernen (erlernen einer Strategie auf Basis von Belohnungen) unterschieden.

Im Folgenden wird hauptsächlich Reinforcement Learning (RL) eingesetzt. Hierbei führt ein Agent beliebige Actions aus. Als Rückmeldung erhält er dann vom Environment den neuen State und einen Reward. Der Reward ist umso höher, je erfolgreicher die Action war. Durch den erhaltenen Reward kann die Ausführung zukünftiger Actions optimiert werden.

Projektbeschreibung

Eine Ursache für Energieverschwendung in der Industrie ist, dass einzelne Anlagenkomponenten zu viel Energie verbrauchen, obwohl sie für die Produktion gerade nicht benötigt werden oder zu diesem Zeitpunkt nichts produziert wird. Die Umsetzung von Standby-Strategien in der SPS, um jede Komponente in einen optimalen energetischen Zustand zu versetzen, wird aufgrund des hohen Programmieraufwandes selten angewendet. Aufgrund der vielen funktionale Abhängigkeiten zwischen den Anlagenkomponenten müsste das SPS-Programm manuell an den jeweiligen Fertigungsprozess angepasst werden. Im Projekt soll ein intelligentes System entwickelt werden, welches sich an die anlagenspezifischen Prozessanforderungen anpassen und autonom Entscheidungen über den optimalen energetischen Zustand jeder Komponente ableiten kann. Hierfür werden RL-Algorithmen verwendet, die auf virtuellen Anlagenmodellen trainieren.

Definition der Testumgebung

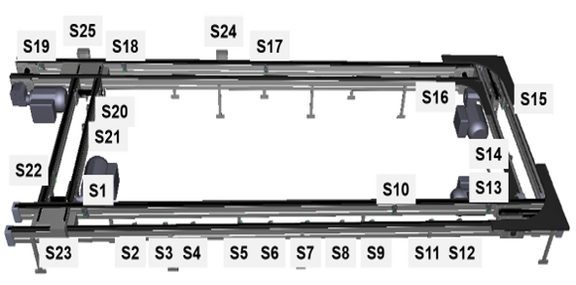

Für einen ersten Test wurde das Ziel festgelegt, die Beförderung der Werkstückträger möglichst energieeffizient zu betreiben. Es sollen somit nur die Förderbänder in Betrieb sein, auf denen gerade ein Werkstückträger fährt.

Folgende States und Actions wurden für das Reinforcement Learning festgelegt:

- Actions: Schalten der einzelnen Förderbänder (4 Actions) oder zweier aufeinanderfolgender Bänder für das Kurvenfahren (4 Actions)

- States: Position des Werkstückträgers, dargestellt durch das Auslösen der Sensoren (25 States);

In folgender Grafik ist die Verteilung der 25 Sensoren in der Anlage zu sehen:

Ergebnisse

Das Video zeigt zuerst den Lernvorgang des Reinforcement Learning-Algorithmus am digitalen Zwilling der SimEM Anlage. Der Agent wählt nach bestimmten Entscheidungskriterien die einzuschaltenden Bänder (Actions) zufällig oder gezielt aus. Wird das passende Band eingeschalten, verfährt der Werkstückträger und der digitale Zwilling (Environment) meldet an den Agenten eine Belohnung (Reward).

Im zweiten Teil des Videos wird die fertig erlernte Q-Table dazu verwendet, im Betrieb eine Entscheidung zu treffen, welche Bänder an- oder ausgeschaltet werden sollen.

This is a modal window.

Abbildung 5: Video zum Ablauf des Reinforcement Learnings